Nun habe ich es, nachdem ich gestern eine Beispielrechnung fand. Allerdings eine alte Rechnung, die mich zunächst verwirrte. Zu DOS-Zeiten soll es eine Regelung gegeben haben, nach der die Endung von Dateien nicht mehr als 3 Buchstaben haben sollten, oder so ähnlich. Jedenfalls kann man an viele Bildformate noch ein w für eine Datendatei anhängen. Bei nicht mehr als drei Buchstaben wurde bei *.tif auf das i verzichtet, seither gibt es eine *.tfw.

Nun ja, es soll auch mehr Druckereien gegeben haben, die Landkarten druckten. Dafür war die Berechnung auf Seite 15 der PDF (Georeferenzierung über das TFW-File). Wenn eine Karte im Maßstab 1 zu 10.000 gedruckt wird, dann entspricht 1 cm auf der Karte gleich 100 Meter real. Wenn diese aber nun mit 300 dpi gescannt wird, kommt dabei ein Wert für die erste und vierte Position von 0,846666666667 heraus. Habe es aber nicht nachgerechnet.

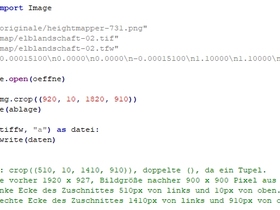

Jedenfalls war ich viel zu hoch mit meinen Testzahlen, musste mich langsam herantasten, wo ich denn nun mit meinen bei Google Maps gemessenen 15 km bleibe. Der Inhalt meiner TFW sieht nun so aus:

0.00015100

0.0000

0.0000

-0.00015100

1.10000

1.10000

Als geografischen Koordinaten 5 und 6 habe ich mir einen Punkt im Atlantischen Ozean in der Nähe des Äquators und des Nullmeridians gesucht, sind somit bedeutungslos und werden ohnehin nicht angezeigt. Hat den Vorteil, dass diese nie geändert werden müssen.

Es können mehrere Heightfelds in einem Verzeichnis liegen, ganz wichtig ist nur, dass die zusammengehörigen TIFs und TFWs einen gemeinsamen Namen erhalten und sich nur durch die Endung unterscheiden.

Die Größen richten sich nach den jeweils gemessenen Entfernungen und können schnell angepasst werden. Habe es quadratisch zugeschnitten, damit ich nicht zweimal messen brauchte, und dabei am Ende noch vertauschen. Zum Beschneiden von Images einige Notizen gemacht, sonst müsste ich später erneut überlegen. Nun sollten sich die einzelnen Schritte mit jedem Bildbearbeitungsprogramm und Texteditor durchführen lassen.

Habe es für den eigenen Gebrauch so geschrieben, dass ich dafür kein weiteres Programm benötige. Nun werden nach den Laden die richtigen Entfernungen angezeigt, wie im ersten Bild. Das zweite Bild ist nur nebenbei und hat nichts mit Terragen zu tun, nur mit den verkürzten Bearbeitungsschritten.

Ergänzend: Terragen berücksichtigt, dass der Abstand zwischen zwei Bogensekunden sich zu den Polen verjüngt. Laut Wikipedia beträgt dieser am Äquator etwa 30,9 m, bei Oberhof etwa 21,1 m, in Mitteldeutschland etwa 19,5 m und bei Sylt etwa 17,7 m.

Bei einem Ausschnitt verjüngen sich die Angaben aber nur für diesen Ausschnitt. Was unten noch 15100 m war, ist dann in Mitteldeutschland nordwestlich Salzwedel nur 14833 m und auf Spitzbergen 14476 m. Bei Google Maps verjüngen sich die Entfernungen ebenfalls etwas, wenn man unten und oben nur von einer Seite bis zur anderen Seite des Monitors misst, somit sollte es sich ausgleichen. Für Spitzbergen:

0.00015100

0.0000

0.0000

-0.00015100

79.75865745927891

16.666384546961652

In Terragen - xyz: 14476, 0, 15111