HDR / HDRI

Post 2

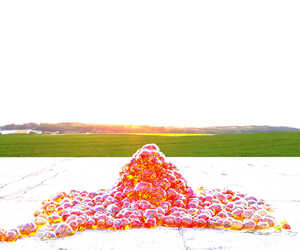

Hier ein direkter "Aufhellungsvergleich" zwischen LDR und HDR, bei gleichem Motiv (Octane Render).

Hier geht es nicht um Schönheit, sondern nur darum, welches Bild "bearbeitungsfähig" wäre, um z.B. Tone Mapping Varianten wie bei den Bildern ganz oben zu erschaffen.

Das ist der Ursprungsrender (16Bit PNG), ganz bewusst mit extremer Lichtsituation:

Die dunklen, fast schwarzen Bereiche interessieren mich besonders. Mal sehen was in der Dunkelheit verborgen ist, also was die LDR bzw. das HDR Bild hergeben. Vielleicht ja ein Felsen.

Das Render Ergebnis habe ich zunächst in den drei zu vergleichenden Dateiformaten abgespeichert.

1. 8Bit PNG (LDR / Gammakorrigiert)

2. 16Bit PNG (LDR / Gammakorrigiert)

3. 32Bit OpenEXR (HDR / linear)

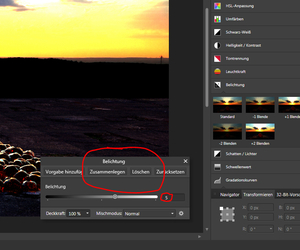

Alle drei Bilder habe ich dann in AffinityPhoto einer recht brutalen Aufhellung unterzogen.

Die Belichtung (Helligkeit) wurde bei jedem Bild um 5 Blendenstufen (LW) erhöht. Bei der linearen EXR noch zusätzlich eine Variante mit 10 LW.

Dabei werden die hellen Bereiche natürlich zerrissen. Aber ich will ja nur wissen, was in der Dunkelheit verborgen ist.

Dies sind die Resultate im klassischen 8Bit und 16Bit PNG Format:

Und hier für 32 Bit OpenEXR +5/10 LW

Die Ergebnisse sprechen für sich. In den gammakorrigierten 8 und 16Bit LDR Bildern hat ein grünes Feld nie existiert, obschon alle Bilder dem gleichen Render entstammen. Es stellt sich also immer die Frage, was für ein Bildformat liegt mir vor. Und wurde bereits eine Gammakorrektur angewendet oder nicht.

Es gibt noch ein weiteres digital-historisches Problem.

Denn wie oben schon mal gehört, es geht immer nur um Licht!

Physikalisch definiert sich Licht über seine Helligkeit (Wellenfrequenz) und die Farbe (Wellenlänge). Mehr ist es nicht. Und doch ist es alles.

In der Realität genauso wie in unseren Render Welten. Das zweite Problem bei LDR Bildern ist...

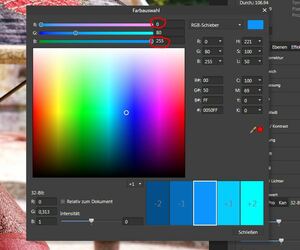

Der 8Bit RGB Farbraum

Der RGB (Rot/Grün/Blau) Farbraum definiert die Farbe und Helligkeit eines Bildpunktes, z.B. auf diesem Bildschirm.

CMYK und andere Farbräume (z.B. für das Druckgewerbe) interessieren zumindest mich eher weniger.

RGB 8Bit / 16Bit / 24Bit / 32Bit ...

Je mehr Bit umso besser. Soviel weiß selbst ich. Mein Betriebssystem rennt inzwischen mit 64Bit. Aber die Bilder wursteln immer noch mit 8 oder maximal 16 Bit pro Farbkanal rum  Neben der Gammakorrektur haben wir hier das zweite Problem. Und beide bedingen einander.

Neben der Gammakorrektur haben wir hier das zweite Problem. Und beide bedingen einander.

Den allgemein gängigen sRGB Farbraum als 24Bit Format zu bezeichnen wäre Schönrederei, denn er besitzt drei Farbkanäle und jeder einzelne verfügt nur über 8Bit,

was nach Adam Riese ganze 256 Helligkeitsstufen je Farbe ermöglicht. Wir reden also über ein Kontrastverhältnis von 256:1 je Farbkanal gegenüber dem unserer Augen von 10.000:1 und mehr. Soviel zum schneidigen Begriff True Color

Dazu kommt, dass das RGB Format zwei klare Grenzen hat. Nichts ist heller als ein RGB weiß (255) und nichts dunkler als ein RGB schwarz (0).

Das bedeutet, unter extremen Lichtsituationen sind dem vielleicht notwendigen Verschieben (Adaption) des Lichtwerteumfangs in die eine oder andere Richtung verlustbringende Grenzen gesetzt. Lichtwerte die ich im Tonemapping über diese Grenze verschiebe und als LDR abspeichere, werden als nicht existent angesehen und einfach abgeschnitten  Wir haben wieder Licht- und Farbinformationen verloren

Wir haben wieder Licht- und Farbinformationen verloren

Grundsätzlich gilt, entferne ich Farb- bzw. Lichtwertinformationen, z.B. durch Gammakorrektur, Tonemapping oder Postwork und speichere die Datei als LDR, sind diese zerstört und niemand kann sie wieder herbei zaubern. Deshalb nennt man HDRI auch zerstörungsfreie Bildbearbeitung

Das 32Bit RGBA Format verfügt je Farbe auch nur über 8Bit. Die in dem Fall vierten 8Bit (4x8=32) sind für den Alphakanal (Transparenz Masken) zuständig.

Am schwachen LDR Kontrastverhältnis ändert sich also auch bei diesem "32Bit" Format nichts.

Auch 16Bit PNG Dateien liefern zwar ein par Bit mehr für die möglichen Farbwerte, sind aber ebenfalls nach oben und unten (0 bis 255) begrenzt, sowie Gammakorrektur verseucht und...

Jeder LDR Datei fehlt die Gleitkomma Option!

Gleitkomma?!

Beispiel:

nach dem Helligkeitswert Blau 212 kommt unvermeidlich der Helligkeitswert Blau 213, obwohl wir an dieser Stelle im Bild vielleicht einen Helligkeitswert Blau 212,5 bräuchten  Pech gehabt. Wir haben die Wahl zwischen einem falschen Blau 212 oder dem falschen Blau 213. Blau 212,5 oder gar 212,7012 sind nicht lieferbar, weil Gleitkommaarithmetik bei 8Bit RGB nicht vorhanden

Pech gehabt. Wir haben die Wahl zwischen einem falschen Blau 212 oder dem falschen Blau 213. Blau 212,5 oder gar 212,7012 sind nicht lieferbar, weil Gleitkommaarithmetik bei 8Bit RGB nicht vorhanden

Es gibt Gleitkomma TIFFs und auch noch andere Formate mit dieser Option. Jedoch sind das allesamt Speichermonster und somit für uns kaum brauchbar.

Nach Möglichkeit will ich die Veränderungen, z.B. beim Tone Mapping, in Echtzeit sehen, und nicht jedes mal eine Kaffeepause einlegen müssen, wie manche das vom Rendern kennen

HDR durch Belichtungsreihen (Compositing)

Diese Lösung haben Fotografen erfunden und der Trick ist vom Grundsatz her recht simpel.

Ich fotografiere - möglichst auf Stativ - ein Motiv mindestens 3 mal, wobei die zweite und dritte Belichtung mindestens eine Lichtwertstufe (über Verschlusszeit) unter bzw. über der Erstaufnahme liegt. Damit habe ich quasi den Dynamikumfang in beide Richtungen verlängert. Auf dem kürzer belichteten Bild habe ich mehr Lichtinformationen (Details) in den Lichtern, auf dem länger belichteten Bild wiederum mehr davon in den Tiefen.

Dummerweise sind es aber 3 Bilder  Die simple Lösung: Compositing

Die simple Lösung: Compositing  Mehr dazu erzählt Euch Tante Wickie und Oma Google

Mehr dazu erzählt Euch Tante Wickie und Oma Google

HDR Kamera?

Mittlerweile hat jede bessere DSLR (und sogar Smartphones) eine eingebaute "HDR Funktion", was aber nur bedeutet, dass die Kamera automatisch mehrere (unterschiedliche) Belichtungen vornimmt, wenn dies vorher eingestellt wurde. Eine echte HDR Kamera, also eine Kamera, die mit einer einzigen Belichtung den gesamten verfügbaren Lichtwerteumfang des Motivs aufnehmen und speichern kann, gibt es nicht. Jedenfalls nicht im Consumer Bereich.

....ähhhh doch, eine gibt es!

HDR Rendering

Eine 3D Renderkamera (PBR) kann tatsächlich mit einer "Aufnahme" einem unseren Augen entsprechenden Lichtwerteumfang erfassen und speichern, mit einem Kontrastverhältnis von bis zu 1.000.000:1  Rendermaschinen arbeiten bereits seit Jahren mit 32Bit. Aber erst das physikalisch basierte Rendern (PBR) in Verbindung mit HDR Dateiformaten nutzt dieses Potential und öffnet uns damit Türen zu neuen Gefilden

Rendermaschinen arbeiten bereits seit Jahren mit 32Bit. Aber erst das physikalisch basierte Rendern (PBR) in Verbindung mit HDR Dateiformaten nutzt dieses Potential und öffnet uns damit Türen zu neuen Gefilden

Die entscheidenden Vorteile des Themas HDR in 3D verteilen sich für mich (bisher) auf vier Bereiche:

1. HDR Bilder rendern (Octane3) Denn das tun PB Rendermaschinen.

2. Echtzeit Imaging (ähnlich Tone Mapping) im laufenden Render (Octane3)

3. 32Bit HDR Ausgabeformat OpenEXR für späteres HDR-Tonemapping, Compositing oder Postwork (AffinityPhoto)

4. HDRI global lighting (Octane3)

5. Rendern sphärischer HDR Bilder für den Einsatz in anderen 3D Szenen als HDR Environments und globale Beleuchtung (Terragen 4 pro)

Jeder wird hier noch andere Bereiche finden und seine eigenen Schwerpunkte setzen.

HDR Dateiformate

Der Unterschied? Na der Dynamikumfang

Man sagt, der Blick auf ein HDR Bild sei wie der Blick durch ein offenes Fenster.

Radiance / .hdr

Der Urvater aller HDR Formate von Greg Ward. Der Witz ist, dass eine Radiance (.hdr) auch nur 3 Farbkanäle besitzt (RGB) und jeder Kanal ebenfalls nur über 8Bit verfügt. Der Trick ist der vierte Kanal, in den Exponenten geschrieben werden, die auf jeden Farbwert in jedem Farbkanal wirken. Es stehen also nicht 255 Helligkeitsstufen pro Farbe zur Verfügung, sondern Ende offen  Das ist alles. Und damit sind Kontrastverhältnisse möglich die in die Fantastillionen gehen

Das ist alles. Und damit sind Kontrastverhältnisse möglich die in die Fantastillionen gehen

Nachteil des .hdr Formates sind Unmengen ungenutzter Werte, welche jedoch durch eine Kompression im Speichervorgang auf einen minimalen Wert geschrumpft werden können.

OpenEXR / .exr

Das Format OpenEXR (.exr) arbeitet mit 16Bit je Farbkanal, was unter Gleitkomma Berücksichtigung über 1 Mrd. Farben ermöglicht, unabhängig von der Lichtwertstufe!  Das darstellbare Kontrastverhältnis reicht bis über eine Million:1 und ist damit für alle Zwecke mehr als genug. OpenEXR kann auch verlustfrei als ZIP archiviert werden.

Das darstellbare Kontrastverhältnis reicht bis über eine Million:1 und ist damit für alle Zwecke mehr als genug. OpenEXR kann auch verlustfrei als ZIP archiviert werden.

OpenEXR scheint sich zu einem Standard entwickelt zu haben. Auch PIXAR und andere Film- bzw. Special Effects Studios arbeiten mit OpenEXR. Kein Wunder. Schließlich kommt OpenEXR aus dieser Branche. Andere HDR Formate wie z.B. Gleitkomma TIFF oder TIFF logluv sind (wie bereits gesagt) Speichermonster und im Consumer Bereich nur wenig oder gar nicht verbreitet.

Entscheidend ist, dass in einer HDR Datei alle Bildinformationen enthalten sind und die Datei, im Gegensatz zu RAW, keinen Konverter benötigt.

Tone Mapping[ (Tonwert Umsetzung)

Tone Mapper versetzen die Tonwerte in einem Bild. Es sind Operatoren, also mathematische Funktionen, die mit der Lichtwerteverteilung spielen.

Im Gegensatz zum klassischen LDR Postwork jedoch zerstörungsfrei, weil HDR. Man nennt sie auch Dynamik Kompressoren, weil sie am Ende ein LDR ausgeben.

Es gibt sie als globale und lokale Operatoren (vgl. Auge: globale und lokale Adaption). Diese Kontrast Trick Kisten sind echt cool und einige gute auch kostenlos, wie der o.g. Picturenaut oder Luminance HDR. In Affinity Photo und auch Photoshop sind solche Mapper bereits eingebaut. Wer nicht den pauschalen Gammastempel auf sein Bild gedrückt haben will, macht Tone Mapping. Selbst ich selbsterklärter nicht-Postworker  Weil's so beeindruckend und so einfach ist

Weil's so beeindruckend und so einfach ist  Siehe die ersten Bilder ganz oben oder die Folgenden.

Siehe die ersten Bilder ganz oben oder die Folgenden.

Tone Mapper pressen also den Dynamikumfang eines HDR zurück in die klassische, also kapazitiv begrenzte 8/16Bit LDR Kiste, mit dem lächerlichen Kontrastverhältnis von 256:1 pro Kanal, damit wir uns das Ergebnis (auch ohne UHD Bildschirm) ansehen können. Natürlich gehen auch dabei Bildinformationen verloren. Aber im Gegensatz zu automatischer Gammakorrektur, entscheide ich welche Tonwerte rausfliegen und welche drin bleiben.

Noch ein Beispiel dazu: Hier habe ich Octane die automatische Gammakorrektur überlassen...

Und bei diesem Bild habe ich entschieden wie die Tonewerte verteilt werden...

Zu viel Sättigung? Beim Tonemapping (im Gegensatz zum Compositing) gibt es kein richtig oder falsch.

Tonemapping heißt, Krativität ohne Grenzten und allein der Betrachter entscheidet ob es ihm gefällt oder nicht.

Voll die Farben, ey!  Weil es einfach Spaß macht

Weil es einfach Spaß macht  Man beachte die Stickerei auf dem Hut.

Man beachte die Stickerei auf dem Hut.

Dieses Blau oben auf dem Hut z.B., habe ich so auf meinem Bildschirm noch nie gesehen. Ist allerdings auch ein UHD Monitor. Ich weiß nicht ob das bei normalen Monitoren auch so rüber kommt. Die JPEG Komprimierung nach hier hat dem Bild ohnehin schon viel genommen. Glaubt mir einfach, dass es klasse aussieht.

In diesem Fall habe ich übrigens Picturenaut verwendet.

Ein kleines aber geniales Programm incl. 4 verschiedener Tonemapper (Operatoren)

Hier eine kurze...

Picturenaut Einweisung:

Wenn das (lineare) HDR Bild geladen ist und auf Tone Mappen gedrückt wurde, zeigt das Histogramm (3) die Lichtwerteverteilung im 8/16Bit RGB Farbraum (0-255) für das zu erstellende LDR Bild an. Dort zunächst unter Luminance (2) den Schwarz- und Weißpunkt korrekt setzen, also an die ersten nennenswerten Lichtwerte heran schieben. Cool ist, dass ich diese auch für jeden der drei Farbkanäle RGB (2) getrennt setzen kann und Picturenaut mir immer die Veränderungen im Histogramm als auch dem Vollbild in Echtzeit präsentiert. Mit den vier verschiedenen Operatoren (1) lassen sich die dollsten Licht- und Kontrastvarianten zaubern.

Picturenaut ist für HDR Anfänger genau das richtige Programm um auf Anhieb zu verstehen, was da eigentlich abläuft, denn er zeigt es mir in Echtzeit.

Verändere ich z.B. die Belichtungszeit, sehe ich - neben der Veränderung im Vorschau Bild - auch im Historgramm wie sich die Lichtwerte Verteilung ändert, usw. ...

Postwork

Im klassischen 32Bit HDR Postwork, läuft es genauso. Helle ich ein HDR Bild auf oder dunkle es ab, (siehe LDR/HDRVergleichsbilder oben) funktioniert es plötzlich so wie schon immer gewünscht  Jetzt tauchen tatsächlich Details in sehr hellen oder sehr dunkeln Bereichen auf, die vorher nicht da waren, weil sie in einem LDR Format auch tatsächlich nicht existierten.

Jetzt tauchen tatsächlich Details in sehr hellen oder sehr dunkeln Bereichen auf, die vorher nicht da waren, weil sie in einem LDR Format auch tatsächlich nicht existierten.

Zauberei? Nein. Nur mehr Lichtinformationen. Zerstörungsfreie Bildbearbeitung eben  Heißt weniger Artefakte, kaum noch Bildrauschen, keine Zahnlücken im Histogramm und all die anderen Probleme mit denen Postworker sich bei einer LDR Bildbearbeitungen rumschlagen müssen.

Heißt weniger Artefakte, kaum noch Bildrauschen, keine Zahnlücken im Histogramm und all die anderen Probleme mit denen Postworker sich bei einer LDR Bildbearbeitungen rumschlagen müssen.

Das Ende der Gammakorrektur?

Nun ja, es wird wohl noch etwas dauern, bis HDR Dateiformate zum "Ausgabe Standard" für alle beteiligten Geräte werden. Aber er wird kommen.

Die ersten bezahlbaren HDR PC Monitore (UHD) stehen bereits in den Läden. Auch HDR TV Screens gibt es bereits, basieren aber auf anderen Techniken und Farbsystemen.

Ich will aber nicht compositen oder postworken. Ich will nur gute Render erstellen!

Tja, der Spruch könnte von mir sein  Deshalb werde ich (beizeiten) noch einen dritten Post nachschieben,

Deshalb werde ich (beizeiten) noch einen dritten Post nachschieben,

wie ich in meiner Renderengine Octane bereits "tone mappe", und zwar während der Render noch läuft

![]()

![]() Nun, dies ändert sich gerade...

Nun, dies ändert sich gerade... ![]()

![]() Damit prahlen (und lügen) ja alle

Damit prahlen (und lügen) ja alle ![]()

![]() Diese Ebene markieren und auf Anpassungen wechseln. Dort einen der etlichen Filter auswählen (hier Gradationskurve) und schon wird diese Anpassung als weitere Ebene angelegt, selbige ist ab und zuschaltbar, verschiebbar oder auch als Child an jede andere Ebene anzuhängen. Filter können also direkt auf das Grundbild, oder als separater Layer, oder aber als Filter auf einen Layer angewendet werden.

Diese Ebene markieren und auf Anpassungen wechseln. Dort einen der etlichen Filter auswählen (hier Gradationskurve) und schon wird diese Anpassung als weitere Ebene angelegt, selbige ist ab und zuschaltbar, verschiebbar oder auch als Child an jede andere Ebene anzuhängen. Filter können also direkt auf das Grundbild, oder als separater Layer, oder aber als Filter auf einen Layer angewendet werden.![]()

![]() Und am Ende hat man dann z.B. sowas...

Und am Ende hat man dann z.B. sowas...![]()