Nur eine kleine Zusammenfassung, wofür die im Faden "Probleme ... im Alter" erwähnten Apps eigentlich gut sind.

Normalerweise wird an einem Rechner mit einem Screen von entsprechender Größe gearbeitet. Das betrifft eigentlich alles, gleich ob 3D, Bilder, Texte, Gestaltung von eigenen Webprojekten und Webseiten, Videos usw. Doch was, wenn kein größerer Rechner zur Verfügung steht, und viele Projekte auf einen weiteren Ausbau warten?

Ein Smartphone ist zwar dann nur ein kümmerlicher Ersatz, doch völlig unmöglich ist es nicht.

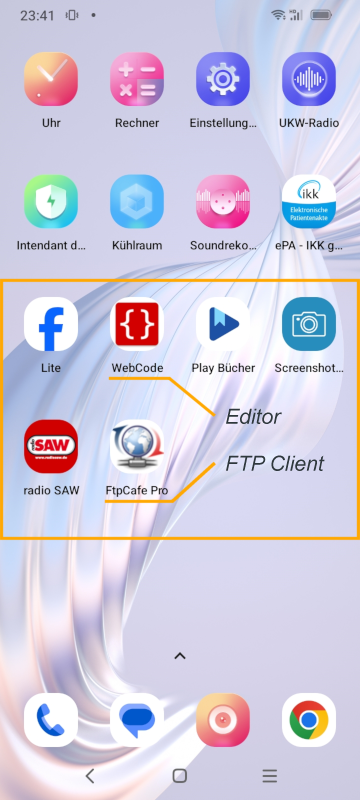

Um es zu testen, hatte ich mir einen Editor und einen FTP Client als App installiert, beide werden in diesem Fall benötigt.

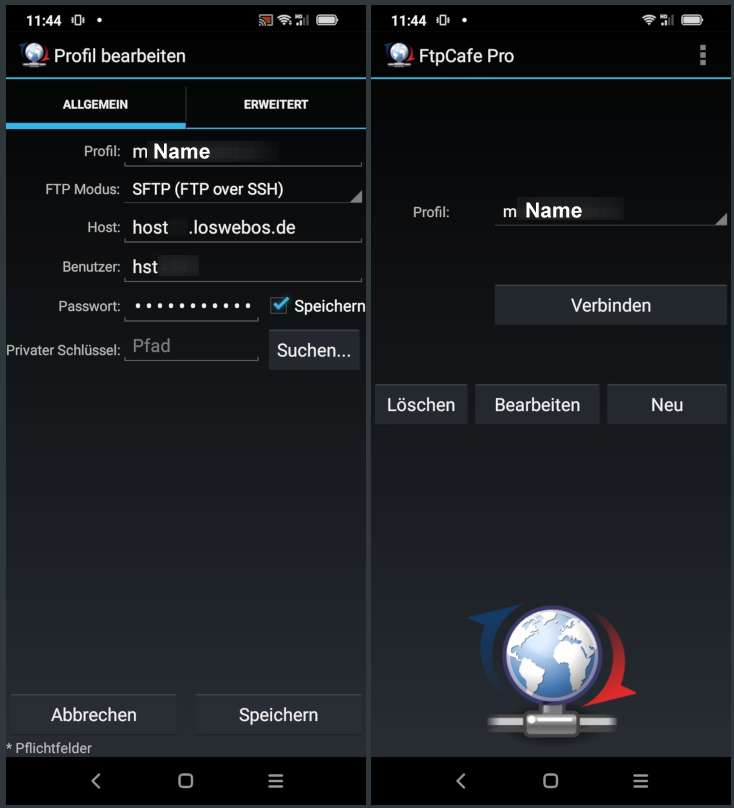

Als Erstes wird ein Profil angelegt, um auf dem eigenen Webspace bei einem Hoster zugreifen zu können. Bei den ersten drei Apps kam ich damit nicht klar, bei der vierten App klappte es dann, nachdem ich mir die Anleitung vom Hoster noch einmal durchlas und daraufhin den Modus wechselte. Unterschiede zwischen den Anbietern gibt, lesen muss man die Anleitungen immer, doch sind diese meistens auf bekannte Desktop-Anwendungen zugeschnitten, nicht auf Puppenstuben-Apps. Gut, es hat geklappt, etwas habe ich noch zusätzlich geschwärzt/ausgegraut, fehlendes geht aus den eigenen Daten beim Hoster hervor, das Prinzip bleibt ersichtlich.

Dem Profil einen Namen geben.

Nach dem Speichern des Profils wird es einfach, denn bei jedem erneuten Aufruf braucht man nur noch auf Verbinden klicken.

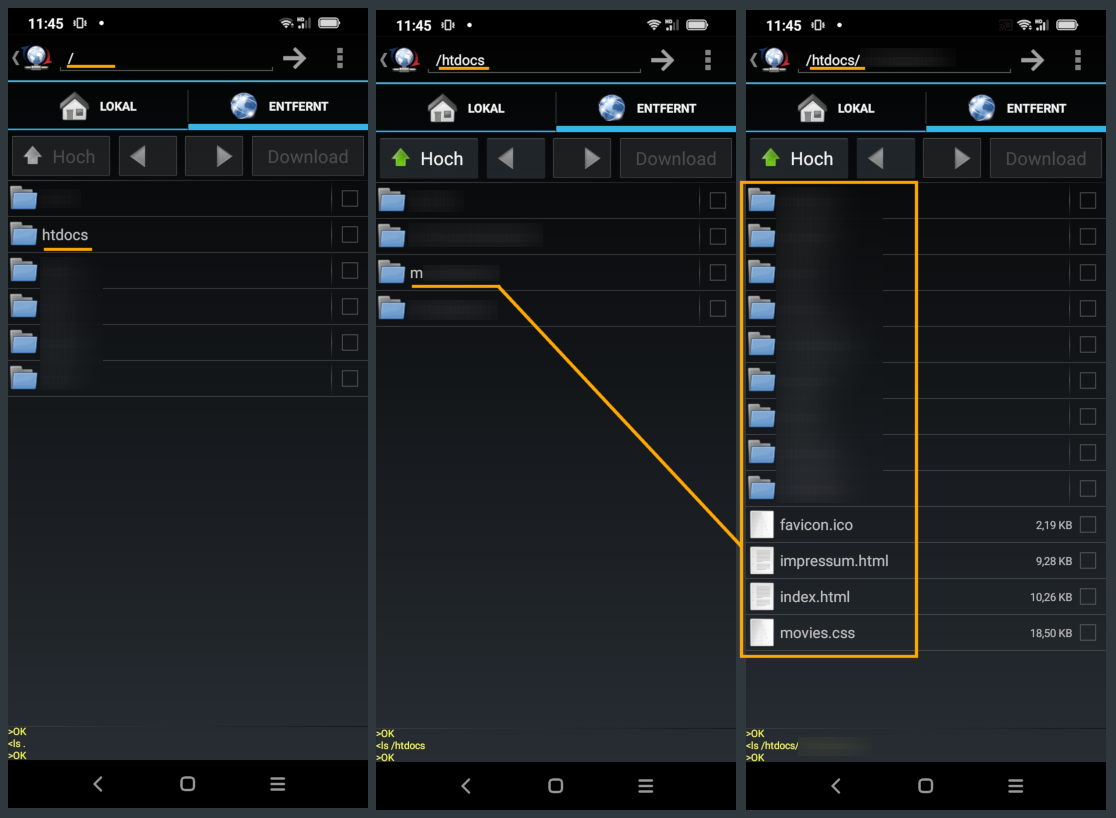

Nachdem die Verbindung steht, landet man im obersten Verzeichnis vom Webspace, falls im Profil kein zusätzlicher Pfad angelegt wird. Habe auf einen zusätzlichen Pfad verzichtet, weil ich es gewohnt bin, mich durch die Ebenen und Verzeichnisse zu klicken. Jedenfalls, so sieht es auf dem entfernten Server aus, von dem man zu bearbeitende Datei herunterladen oder bearbeitete Dateien hochladen kann. Auf einem größeren Screen einfacher, weil man dort das lokale und entfernte Fenster nebeneinander sieht, und per Drag and Drop arbeiten kann. Doch es geht halt ebenfalls mit dem Handy.

Ein weiteres Problem tat sich auf. Au einem auf der SD-Karte angelegten Arbeitsverzeichnis konnte zwar der Editor zugreifen, ich schaffte es aber nicht, den FTP Client ebenfalls auf dieses Verzeichnis zugreifen zu lassen. Also lud ich erst einmal vorhandene Dateien herunter, da stand zwar etwas von "Verzeichnis anlegen", es wurde nur keine Tastatur eingeblendet, um dem neuen Verzeichnis einen Namen zu geben.

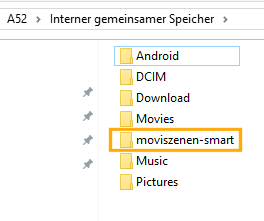

Also habe ich dieses über USB angelegt, danach am Desktop-Rechner alle heruntergeladenen Dateien in dieses Verzeichnis verschoben. Nun können beide Apps darauf zugreifen.

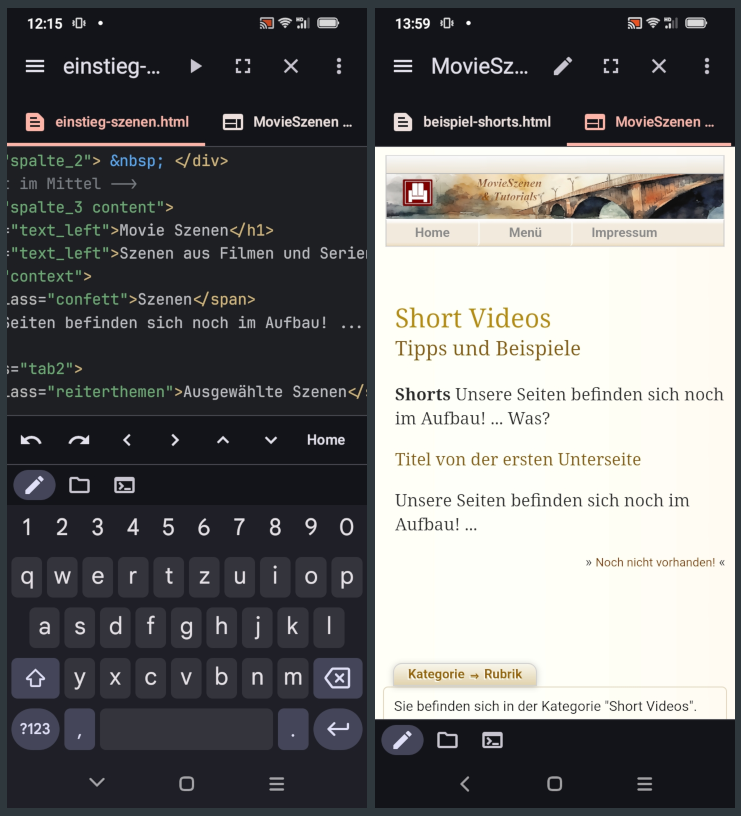

Im Editor kann man nun zwar kein neues Design entwickeln, dazu ist alles zu klein und man sieht in der Vorschau nicht viel, scheinbar werden nicht einmal Bilder geladen, doch man kann im Quelltext z.B. noch nicht vorhandene Beschreibungen für Rubriken einfügen, oder anderes, und in der Vorschau betrachten, danach hochladen. Und im Quelltext zu arbeiten, das kann wohl ohnehin jeder, der am Desktop mit dem Notepad++ arbeitet, jeder ernsthafte Webdesigner dürfte wohl ebenfalls dazu in der Lage sein.

Doch heute werden in der Vorschau auch Bilder geladen (gestern noch nicht), nur der Screenshot von der Quelltext-Seite stimmt nicht mit der Seite von der Vorschau überein, weil der linke Screenshot von gestern ist und der rechte von heute, dabei zwei unterschiedliche Seiten geladen hatte.

Gut, das sollte als kleine Anleitung genügen.

Mit den anderen Projekten hänge ich nicht weniger hinterher, dafür waren ja z.B. Szenen mit Neandertaler gedacht, ebenso was den Transport von Megalithen anbelangt. Und ob ich das alles noch in einem akzeptablen Zeitraum schaffe, richtig sicher bin ich mir nicht. Nun eins nach dem anderen.